O mundo – esse hipermercado gigante com Wi-Fi – decidiu que já não precisa de médicos. Agora também já não precisa de psicólogos. “Tenho uma dor na garganta há meses… o que será?” pergunta o cidadão moderno, como quem pergunta ao Google se deve usar meias com sandálias. A resposta não vem com estetoscópio nem diploma. Vem com algoritmos, padrões de linguagem, e a assustadora certeza de quem nunca teve medo de morrer.

Recentemente, um homem irlandês – com a coragem que só a ignorância digital permite – decidiu confiar no ChatGPT para avaliar os sintomas de uma dor persistente na garganta. O robô, solícito e educado, terá dito algo como: “Não se preocupe, provavelmente é uma infeção viral.” O tempo passou, como sempre passa, e quando finalmente apareceu um médico de carne, osso e especialidade, o diagnóstico era aquilo que ninguém quer ouvir: cancro em estado avançado.1

Ora, se isto acontece com sintomas físicos claros, imagine-se no território pantanoso do sofrimento psicológico. Onde é que termina a dúvida existencial e começa a depressão? Quem é que, senão um bom psicólogo ou neuropsicólogo, consegue distinguir a ansiedade “normal” de um transtorno obsessivo-compulsivo? E que IA, por mais brilhante que seja, pode compreender a dor escondida num silêncio?

Em 2025, a moda – e aqui moda é quase um diagnóstico – é a autoajuda digital. Basta abrir o telemóvel e escrever: “Sinto-me vazio.” O chatbot, com a empatia artificial de quem leu mil livros de autoajuda em milissegundos, responde: “Isso é normal. Medite. Respire. Tome um chá.” E pronto. É como se tivéssemos tratado o trauma de infância com camomila.

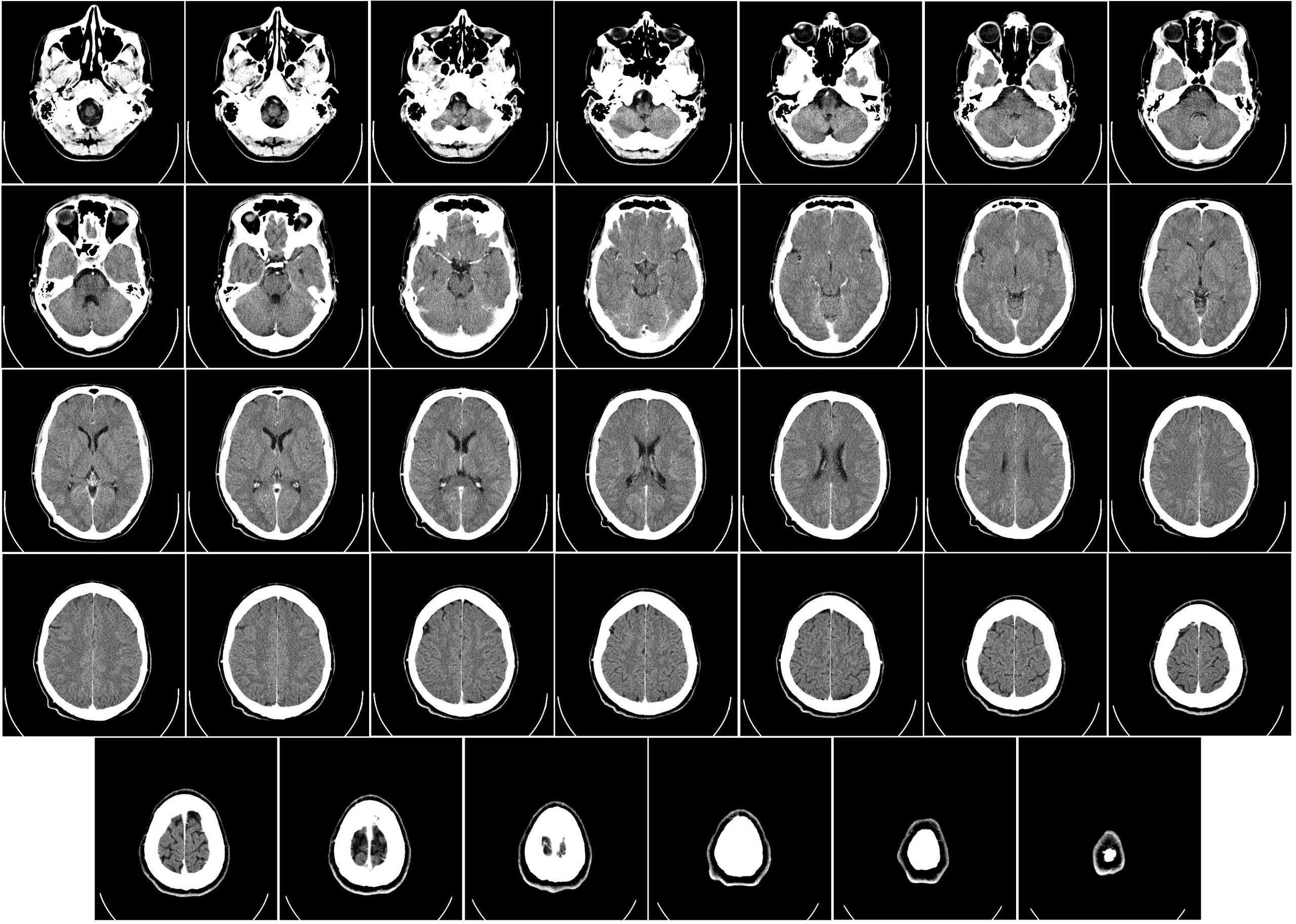

Mas há aqui perigos sérios. Diagnósticos neuropsicológicos, como a demência fronto-temporal ou a esquizofrenia paranóide, são muitas vezes confundidos com stress, fadiga, ou, pior, falta de propósito. Só um profissional treinado, com baterias cognitivas, entrevistas clínicas e olhos atentos, pode diferenciar o esquecimento normal da velhice de uma deterioração progressiva do lobo temporal.

As implicações éticas são assustadoras. Quem é responsável quando um chatbot falha? O programador? A empresa? O servidor na nuvem? E o sigilo? As sessões de terapia, tradicionalmente protegidas pelo silêncio cúmplice da confidencialidade profissional, passam agora por servidores espalhados pelo mundo, expostos a hackers e algoritmos publicitários. Como confiar numa entidade que, enquanto nos consola, recolhe os nossos dados para vender artigos ou conteúdos personalizados?2

A deontologia também sofre. A psicologia clínica é um campo regido por códigos éticos: o respeito pela autonomia do paciente, a beneficência, a não maleficência, a justiça. Chatbots não têm ética (para já…). Têm instruções. E mesmo que um programador tente ensinar-lhes “compaixão”, essa compaixão nunca vem do lugar onde a empatia verdadeira nasce: da experiência humana de sofrer e continuar a amar, sem falar que não existe mente sem corpo e muito menos consciência de si.

Há também a questão da transferência. O clássico Freud acreditava que, mais do que escutar, o psicoterapeuta recebe3. A carga emocional que o paciente deposita no psicólogo é parte do processo. No chatbot, não há sujeito nem relação. É como fazer eco numa gruta: as palavras voltam, mas ninguém as segura.

Se me perguntarem se a inteligência artificial pode complementar intervenções em saúde mental, direi que sim. Tal como um livro de “biblioterapia”, um diário introspetivo ou uma conversa empática entre pares, a IA pode servir como instrumento auxiliar, isto é, útil, até confortador, em momentos de maior vulnerabilidade emocional. Pode oferecer psicoeducação pré-suficiente, sugestões genéricas de coping, até algum alívio momentâneo.

Mas substituir o psicólogo clínico, o psiquiatra ou um neuropsicólogo? Pretender que um chatbot compreenda, contenha e interaja com os fenómenos transferenciais, ou que navegue com competência pela contra transferência, aliança terapêutica e ética do cuidado relacional ou empatia, é confundir tecnologia responsiva com presença terapêutica autêntica.

A IA não possui intencionalidade, responsabilidade profissional nem a capacidade de fazer interpretação clínica situada. Não capta a linguagem do corpo, a hesitação do olhar, a oscilação do discurso, sinais subclínicos que muitas vezes são a porta de entrada para o diagnóstico precoce de perturbações como o transtorno bipolar, o burnout crónico ou o declínio neurocognitivo insidioso.

Confiar a condução de um processo psicoterapêutico a uma interface algorítmica — por mais avançada que seja — é tão incongruente quanto pedir a um micro-ondas que toque uma sonata de Chopin. Pode haver som, pode haver movimento, mas não há música e , sobretudo, não há escuta.

- https://www.thehealthsite.com/news/irish-man-diagnosed-with-stage-four-cancer-with-10-survival-chances-after-using-chatgpt-1258102/ ↩︎

- https://theconversation.com/ai-tools-collect-and-store-data-about-you-from-all-your-devices-heres-how-to-be-aware-of-what-youre-revealing-251693 ↩︎

- https://pmc.ncbi.nlm.nih.gov/articles/PMC10575551/ ↩︎